Vous avez des pages Web de faible qualité ou inutiles, qui impactent votre budget crawl et nuisent à votre référencement naturel ? Vous cherchez une méthode propre et efficace pour désindexer une page Web ?

Voici plusieurs astuces pour supprimer vos pages Web des index des moteurs de recherche !

Pourquoi désindexer une page Web ?

Si des pages Internet de faibles qualités nuisent à l’expérience utilisateur, elles envoient aussi un message négatif aux algorithmes des moteurs de recherche. Pour pallier à cela, certaines pages de votre site Web doivent donc ne plus être référencées.

Le problème sur Internet, c’est que vous ne pouvez pas supprimer une URL de page d’un claquement de doigts. Vous devez respecter un processus bien précis, à commencer par la désindexation de votre page sur les moteurs de recherche.

Il existe plusieurs cas de figure qui peuvent vous amener à devoir désindexer une page Web :

- Vous avez des pages qui contiennent du contenu dupliqué interne ;

- Certaines pages ont été indexées par erreur ;

- Vous avez des pages inutiles qui nuisent à votre SEO ;

- Certaines pages posent un problème d’ordre juridique.

Qu’est-ce qu’une page indexée ?

Pour qu’une page Web apparaisse dans les résultats des moteurs de recherche, il faut que les robots d’exploration qui visitent et analysent les sites Internet ajoutent la page du site à leur index.

L’indexation d’une page par les robots d’exploration n’est possible que si :

- La page que vous souhaitez référencer est crawlable par les robots et donc non bloquée par le fichier robots.txt.

- Qu’elle soit indexable, c’est-à-dire qu’elle remplisse tous les critères techniques d’indexation.

Mais attention : une page indexable n’est pas obligatoirement indexée par Google ! Le moteur de recherche peut parfaitement décider de ne pas l’ajouter à son index pour X raisons (qualité de la page à revoir, qualité du site dans sa globalité…).

De plus, Google attribue un budget de crawl à chaque site. Ce budget correspond au nombre de pages que le robot d’indexation (Googlebot pour Google) va explorer. Il est défini en fonction de plusieurs critères d’exploration tels que la vitesse de chargement de la page, la profondeur de la page, la qualité du contenu…

Ainsi, pour augmenter votre budget crawl et/ou déréférencer des pages indésirables, une désindexation est parfois nécessaire…

Robots.txt : pour empêcher l’indexation

Le fichier robots.txt comme son nom l’indique est uniquement destiné à donner des informations sur votre site aux robots d’exploration. C’est lui qui va leur indiquer quelle page Web crawler ou non. Ainsi, le fichier robots.txt ne va pas vous aider à désindexer une page Web, mais uniquement à faire en sorte qu’elle ne soit pas indexée.

Si vous souhaitez empêcher l’indexation de nouvelles pages Web ou d’un nouveau site, voici la marche à suivre :

- Vérifier la présence du fichier robots.txt à la racine de votre serveur en tapant votre nom de domaine suivi de /robots.txt depuis votre navigateur (normalement il est généré automatiquement par votre CMS à la création de votre site) : https://votresite.com/robots.txt

- Si le fichier n’apparaît pas, vous allez devoir le créer. Attention : suivez bien les consignes de Google lors de la création de votre fichier robots.txt.

Ensuite, trois commandes sont disponibles :

- User-agent pour désigner quel crawler a l’autorisation ou non de parcourir votre site Web.

- Allow pour autoriser le crawlage de la page.

- Disallow pour l’interdire.

Une fois votre fichier terminé, importez-le sur votre site Internet. L’importation de votre fichier va dépendre de votre serveur et de l’architecture de votre site Web. Si vous rencontrez la moindre difficulté, consultez la documentation de votre hébergeur ou contactez-les.

Lorsque votre fichier est importé, testez-le pour vérifier qu’il soit accessible au public et qu’il soit correctement balisé grâce à l’outil de test de la Search Console.

La balise « noindex » : la méthode préférée de Google

La balise meta « noindex » est le meilleur moyen d’empêcher une page Web de s’afficher dans les résultats de recherche de Google. Lorsque Googlebot reviendra explorer votre site, la balise « noindex » va lui signifier de ne pas indexer ou de désindexer une page Web.

Non seulement c’est la méthode préférée de Google, des webmasters et des développeurs, mais c’est aussi la plus facile à mettre en place, car elle ne requiert pas de connaissances techniques particulières.

Voici le code source à ajouter à votre page pour désindexer une page :

- Sur la page ou le groupe de pages HTML que vous souhaitez exclure de la SERP, ajoutez le code suivant dans le <head> de votre site : <meta name=”robots” content=”noindex”>.

- Si vous ne voulez pas que les robots d’exploration n’indexent pas votre page et ne suivent pas vos liens, ajoutez cette directive : <meta name=”robots” content=”noindex,nofollow”>.

- Pour demander aux robots de ne pas indexer une image : <meta name=”robots” content=”noimageindex”>.

Vérifiez bien que votre fichier robots.txt ne bloque pas l’accès aux pages concernées !

Vous avez la possibilité de bloquer l’accès uniquement au robot Google (ou à tout autre crawler comme bingbot pour Bing, Qwantify pour Qwant…), en remplaçant “robots” par “googlebot”.

Pour que votre demande de désindexation soit effective, vous devez attendre le passage des robots. Toutefois, vous pouvez accélérer le processus depuis la Search Console en envoyant une demande de crawl à Google.

L’entête HTTP X-Robots-Tag noindex pour désindexer des fichiers sans code source

Certains fichiers (PDF, images, documents Word…) et pages Web et fichiers ne contiennent pas de code source. Seule la mise en place de l’entête HTTP X-Robots-Tag noindex peut donner les consignes de désindexation aux robots.

Attention, cette technique demande une certaine expertise et si vous ne possédez pas les connaissances nécessaires, il est préférable de faire appel à un développeur. Une mauvaise manipulation peut causer de graves dysfonctionnements sur votre site !

Commencez par modifier votre fichier .htaccess en intégrant les codes suivants :

Pour désindexer tous vos PDF :

<Files ~ “\.pdf$”>

Header set X-Robots-Tag “noindex”

</Files>

Pour désindexer tous vos fichiers images :

<Files ~ “\.(png|jpe?g|gif)$”>

Header set X-Robots-Tag “noindex”

</Files>

Les codes HTTP 404 et HTTP 410 pour désindexer les pages supprimées

Lorsque vous supprimez des pages web, leur désindexation n’est pas immédiate. Si aucun élément ne vient remplacer vos pages, ajoutez l’un des deux codes pour confirmer à Google leur désindexation :

- Code 404 (not found) : la ressource n’existe pas.

- Code 410 (gone) : la ressource n’existe pas et ne sera pas remplacée.

La balise canonical pour désindexer des contenus similaires Si vous des contenus identiques ou similaires, vous risquez d’être pénalisé pour duplicate content. En ajoutant une balise canonical, vous indiquez à Google que seule la page concernée est à prendre en compte.

Ajoutez ce code dans la partie <head> de toutes les pages de contenu dupliqué de votre site Internet en intégrant l’URL de votre page principale : < link rel=«canonical» href=« https://votresite.com/page-exemple/» / >.

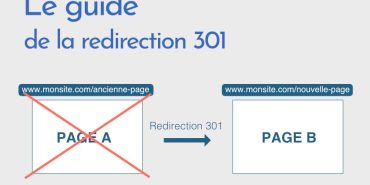

Désindexer une page sans perdre ses backlinks

Les backlinks sont indispensables pour votre optimisation SEO et il serait dommage des liens entrants de qualité !

Pour ne pas perdre vos backlinks, mettez en place une redirection 301 de l’ancienne page vers la nouvelle. Attention, la redirection permanente s’effectue dans le fichier .htaccess de votre serveur !

Pour une page :

RedirectPermanent /repertoire/page-a-rediriger.html https://www.exemple.net/repertoire/page-de-destination.html

Pour un répertoire :

RedirectPermanent /repertoire https://www.nom-de-domaine.com/repertoire-de-destination

Pour un domaine :

RedirectPermanent / https://www.nom-de-domaine.com/

Désindexer une page Web avec WordPress

Les utilisateurs de WordPress n’ayant pas accès à la partie <head> de leurs pages, la solution la plus simple est d’installer le plugin Yoast.

Une fois l’installation terminée, allez sur la page à désindexer, puis dans l’onglet Yoast, cliquez sur « Avancé ». Sélectionnez « Non » à la question « Autoriser les moteurs de recherche à afficher le contenu Article dans les résultats de recherche ? ». Enregistrez, et c’est tout !

À lire aussi : Déréférencement Google : faire votre demande en 8 étapes

Notre astuce pour désindexer une page

Vous connaissez désormais les techniques pour désindexer une page Web. Si vous avez de nombreuses pages à désindexer et que vous voulez accélérer leur désindexation, créez un fichier sitemap dans lequel vous listerez toutes les URL à désindexer et déclarez le fichier dans la Search Console.

Pour éviter d’avoir à désindexer des pages Web parce que vos contenus sont pauvres, optimisez vos textes en SEO et en qualité en faisant appel à nos rédacteurs web professionnels.