Si vous souhaitez réaliser un audit SEO pour améliorer le référencement naturel de votre site internet, vous allez avoir besoin d’outils de crawl.

Les logiciels de crawl vont simuler le comportement des robots d’exploration de Google et vous fournir un diagnostic complet des points de friction qui empêchent votre site d’entreprise d’être dans les premiers résultats des moteurs de recherche.

Pour vous aider à optimiser votre site web, voici quelques crawler à utiliser dans votre audit SEO.

Quelques définitions de base

Utiliser des outils c’est bien, mais encore faut-il comprendre à quoi ils servent. Voilà une petite piqûre de rappel sur des notions importantes : crawler, SERP et référencement naturel.

Qu’est-ce qu’un crawler ?

Un crawler est donc un logiciel qui va scanner votre site internet comme le feraient les robots d’indexation. Ces robots, dont le plus célèbre est le Googlebot de Google, vont parcourir l’ensemble de votre site pour l’indexer. Le robot va ainsi visiter votre site en suivant les différents liens et récupérer au passage toutes les informations du site.

Les données collectées sont ensuite intégrées à l’index du moteur de recherche Google et serviront à classer votre site sur une requête précise.

Un crawler agit à l’identique et va donc relever tous les problèmes éventuels qui pourraient empêcher une bonne indexation de votre site. Il va vous fournir une mine d’informations qui, une fois corrigées, vont vous permettre d’améliorer votre positionnement dans les SERP.

L’enjeu du référencement naturel dans la SERP

La SERP désigne les résultats d’une requête sur un moteur de recherche. Les sites ayant le meilleur référencement naturel se trouveront en haut du classement. Grâce aux robots de Google par exemple, l’URL le mieux optimisé sera le plus vu par les utilisateurs.

Plusieurs logiciels, dont certains seront détaillés par la suite, vous permettront de réaliser des tests réguliers de vos sites internet. Tous les problèmes de référencement pourront être signalés. C’est grâce à ces robots, mis à votre disposition que vous saurez quel code ne fonctionne pas, si une méta description doit être changée, ou si des balises sont mal placées. C’est une façon efficace et sûre d’optimiser vos contenus pour dépasser vos concurrents.

Les meilleurs crawlers pour votre audit SEO

Un bon crawler doit être capable de mettre en évidence les problèmes liés aux trois fondamentaux du SEO :

- La pertinence de votre contenu de site : les méta descriptions, le duplicate content, vos URLs…

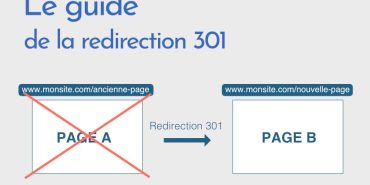

- La structure technique de votre site : redirections, erreurs 404, le maillage interne…

- L’efficacité de votre stratégie de backlinks (les liens entrants).

1. Screaming Frog : le meilleur crawler

Screaming Frog est un crawler gratuit jusqu’à 500 analyses. L’outil est extrêmement complet et va extraire tous les éléments de votre site depuis son URL. Il vous fournira alors une base de données conséquente pour corriger vos problèmes de :

- Méta-description

- Balises titre

- Mots-clés

- Titres H1 et H2

- Poids d’images

- Erreurs 404 et 500

- Redirections 301 et 302

- Liens internes et externes…

De plus, le logiciel intègre Google Analytics, Google Search Console et Majestic SEO. Bref, c’est un outil très puissant et si vous avez un budget crawl conséquent, il est conseillé d’opter pour sa version payante pour profiter de toutes ses fonctionnalités.

Le budget crawl représente le nombre de pages limites explorées par les bots. Ce budget tient compte de plusieurs critères comme la vitesse de réponse du serveur, la profondeur de la page, la fréquence des mises à jour ou encore la qualité du contenu du site. Plus votre site sera optimisé et plus votre budget sera conséquent et plus vous aurez donc de chance d’atteindre la première position sur le moteur de recherche.

À lire aussi : Balise meta robots : comment l’utiliser ?

2. Xenu : le plus connu des crawler

Xenu est un crawler gratuit, léger et facile à utiliser. Là encore, il vous suffit d’entrer l’URL de votre site et l’outil va analyser l’ensemble de vos données. Selon la taille du site, le diagnostic peut prendre quelques heures. Parmi ses particularités, il a la possibilité d’identifier tous les liens brisés et d’analyser les liens JavaScript. Toutes vos données pourront être exportées au format CSV pour être ensuite traitées sur Excel.

Les résultats de l’audit se présentent sous la forme d’un tableau dans lequel apparaît l’adresse des pages comportant une anomalie. Pour chaque URL, le logiciel Xenu indique quel est la particularité des problèmes détectés.

Il s’adapte à tous les ordinateurs : Linux, Mac et Windows.

3. LinkExaminer : le petit frère de Xenu

Ce logiciel a l’avantage de ne pas être très lourd et plutôt vif. LinkExaminer est aussi un crawler gratuit. Il ressemble beaucoup à Xenu à quelques détails près, comme notamment l’absence de la balise Meta Keywords. L’outil vous permet aussi de télécharger vos données. C’est un logiciel qui a la capacité de générer un fichier sitemap XML. Et, comme Xenu, vous pouvez traduire vos données en fichier CSV.

Pour info

un fichier sitemap XML est un fichier qui contient toutes les pages d’un site Web sous forme de lien. Il est utile de générer le fichier si vous avez un site volumineux pour faciliter le travail des bots et de l’intégrer à la racine de votre site, dans le fichier robots.txt. Ou en l’envoyant sur la Search Console.

Il faut saisir l’URL du site à analyser, de la même manière que pour Xenu. Les robots vont alors délivrer les informations nécessaires pour arranger les problèmes de votre site web.

4. OnCrawl : pour l’analyse de logs

OnCrawl est un outil payant dont la fonctionnalité principale est l’analyse de logs. Il observe ainsi la façon dont Googlebot scanne votre site, mais aussi sa fréquence de passage et la durée de ses visites. Vous allez ainsi pouvoir croiser ses analyses de logs et ses résultats de crawl pour un diagnostic beaucoup plus complet.

Ce logiciel va optimiser son exploration de manière à vous signaler la présence de pages internet orphelines ou non intégrées dans votre site de façon appropriée.

S’il n’est pas gratuit, ce robot de test de logs et de crawl est très complet pour une stratégie marketing intégrale. Il vous permet d’explorer toutes les solutions d’optimisation. Vous n’aurez pas besoin d’outils de suivi de mots clés comme Semrush, car c’est l’une des fonctionnalités intégrées à OnCrawl.

5. SEO Crawler de Rob Hammond : le crawler gratuit jusqu’à 350 URLs

Ce logiciel est particulièrement indiqué pour l’analyse des redirections des sites internet et des URLs canoniques. Très facile à utiliser, comme ses concurrents, il suffira d’entrer l’adresse d’un site internet pour obtenir un résultat très rapide. Un tableau apparaît, que vous pouvez télécharger en TSV.

Pour une exploration plus ciblée, selon vos souhaits, vous pouvez affiner votre demande grâce à une option de recherche avancée. C’est aussi l’avantage de cet outil.

6. Cyotek WebCopy : le crawl gratuit en hors ligne

S’il est capable de fonctionner en ligne comme tous les autres crawlers, celui-ci offre la possibilité dupliquer des pages de sites web afin de travailler hors connexion.

Avec des possibilités de commandes très flexibles, les robots du Cyotek pourront aller jusqu’à faire des tests de documents ou chaînes d’agents utilisateurs ciblés.

7. HTTrack : pas besoin de budget crawler

Avec des versions adaptées à Windows, Linux, Unix ou encore Sun Solaris, il permet de télécharger des sites internet complets sur PC. Vous pouvez ainsi travailler en miroir et suspendre l’activité pour la reprendre plus tard.

Le choix des options invite l’utilisateur à piloter les robots en fonction de ses besoins spécifiques d’analyse. HTTrack offre tellement de possibilités que son utilisation est plutôt prévue pour des utilisateurs adeptes du code HTML.

8. Getleft : le crawler gratuit multilingue

Cet outil s’adapte à 14 langues, ce qui fait sa grande particularité. Simple d’utilisation, ses robots font des tests par capture de pages web. Il est capable de télécharger un site partiel ou entier. Il vous permet d’analyser tous les liens de façon ponctuelle, à la demande.

9. Scraper : pour anticiper le budget crawler

Cet outil gratuit est en fait une extension de Google Chrome qui permet de cibler les URL qui nécessitent une analyse de crawl. C’est l’outil parfait pour préparer son budget crawl dans le cas où l’on choisirait un crawler payant.

Scraper permet de télécharger les résultats des tests directement dans un tableur. Vous pouvez ensuite décider ou non de faire analyser les URLs indiquées dans des logiciels de crawl.

10. OutWit Hub : le crawler gratuit pour débutant

À part la contrainte d’être dépendant du navigateur Firefox, ce logiciel est parfait pour les novices qui n’ont pas de budget crawler. Pas besoin de code pour cet outil. Vous pouvez télécharger des données d’analyses de façon très simple sans connaissance particulière.

11. ParseHub : le logiciel double face

Ce crawler gratuit se télécharger sur bureau de certaines version de Mac, Windows et Linux. Ça, c’était la première face. Pour la seconde, il est capable de s’intégrer directement dans les navigateurs. Vous pouvez ainsi travailler hors ligne, en miroir, actualiser et diffuser le contenu de façon organisée.

12. Visual Scraper : le crawl gratuit organisé

Ce logiciel a l’avantage d’être très ergonomique et intuitif pour une utilisation très simple sans code. Sa deuxième particularité est de laisser la possibilité aux utilisateurs d’anticiper et de planifier leurs actions.

Il est primordial de savoir organiser son plan d’exécution pour une optimisation SEO réussie. Cet outil facilite cette démarche, et c’est probablement ce qui le démarque. Les utilisateurs n’ont plus à s’inquiéter de l’évolution des flux sur internet et de leur place dans les SERP. Le système de rappel de ce logiciel va optimiser l’exécution de tous les projets de façon fluide et pérenne.

13. Scrapy : le crawler open source

Scrapy est un excellent scraper open source. Si vous avez des compétences en développement, vous pouvez créer vos crawlers sur mesure. L’outil fonctionne avec Python et vous permet d’ajouter vos propres fonctionnalités.

Il est alors possible de créer des crawlers qui réalisent les actions de votre choix. Vous pouvez paramétrer Scrapy en écrivant les règles de crawl pour exploiter les données qui vous intéressent.

Pour une solution sur-mesure, optez pour le crawler Scrapy !

Notre conseil

Crawler son site est indispensable pour réaliser un audit SEO complet. Grâce à lui, vous allez pouvoir visualiser tous les points à améliorer pour optimiser votre site. N’oubliez pas non plus de miser sur des contenus de qualité pour augmenter votre expérience utilisateur, attirer plus de visiteurs et booster votre taux de conversion. Pour cela, confiez la création de vos textes à nos rédacteurs web professionnels !