Concevoir un site Internet et le développer n’est pas si simple qu’il n’y paraît, surtout lorsque l’on débute dans l’univers du web. Toutefois, même les webmasters les plus chevronnés commettent des erreurs en matière de SEO si l’on en croit une infographie réalisée par SEMRush.

S’étant intéressé à plus de 100 000 sites Internet et à plus de 450 millions de pages web afin de recueillir des données réellement représentatives, l’éditeur américain de solutions SEO a mis en lumière les erreurs les plus fréquemment commises.

Nous vous les présentons, charge à vous de ne pas les reproduire dans vos propres projets…

1. Une mauvaise configuration du domaine

Sur près de 17 % des sites analysés, une mauvaise configuration du domaine a été observée.

Or, celle-ci est très problématique puisqu’elle peut empêcher les robots de Google de crawler les pages d’un site Internet. Ces dernières ne sont alors pas indexées et n’apparaissent donc jamais dans les résultats du moteur de recherches.

2. La présence de pages renvoyant une erreur 4xx

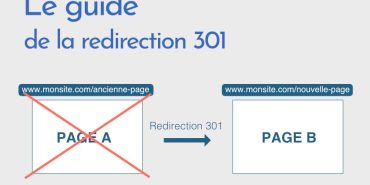

80 % des sites Internet abritent une ou plusieurs pages renvoyant une erreur 4xx, la plus répandue étant la fameuse erreur 404. Celles-ci peuvent considérablement nuire à la popularité d’un site car l’expérience utilisateur n’est pas bonne.

Pour les corriger, certains choisissent de mettre en place systématiquement une redirection vers la page d’accueil. Sachez que c’est là une mauvaise idée car une telle pratique indique à Google qu’il y a un défaut sur votre site. Par conséquent, le moteur de recherches vous pénalisera en matière de référencement.

À lire aussi : 5 erreurs courantes dans la construction de liens internes

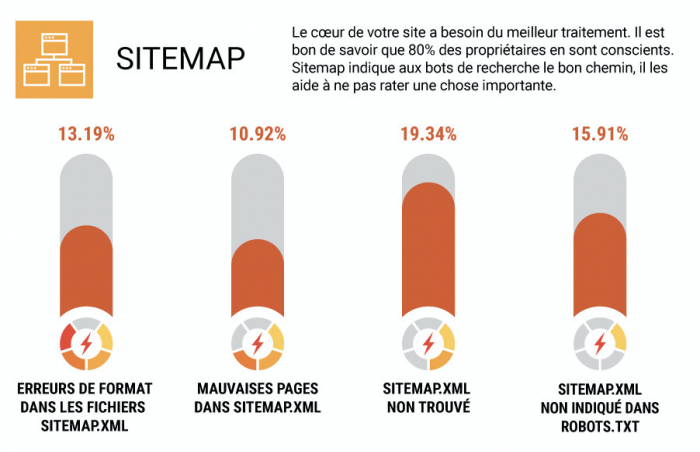

3. Un fichier Sitemap négligé

Censé faciliter l’indexation des pages d’un site Internet mais aussi indiquer aux robots de Google comment est structuré le contenu, le fichier Sitemap est souvent négligé.

Dans 13 % des cas, des erreurs de format sont observées dans ce fichier alors que dans 11 % des cas, de mauvaises pages y apparaissent. Moins grave, bien que gênant, l’étude de SEMRush montre que pour 20 % des sites, les crawlers ne parviennent pas à trouver ce fichier Sitemap.

À lire aussi : Comment réussir la création de votre blog grâce au sitemap marketing ?

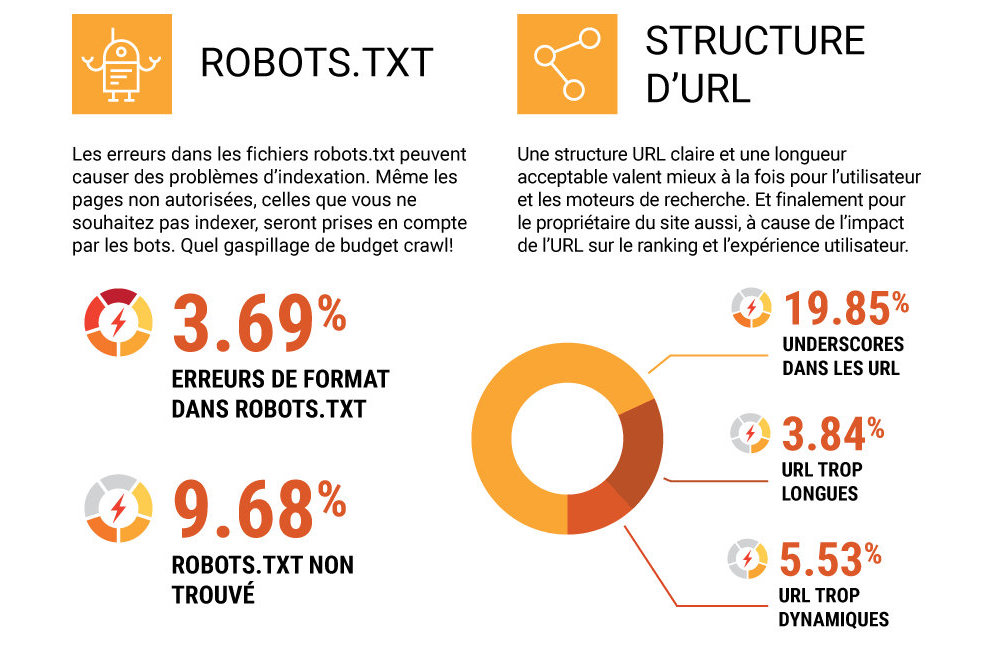

4. De mauvaises structures d’URLs

Les moteurs de recherche apprécient les URLs claires et de longueur acceptable.

Pour autant, des underscores sont trouvés dans près de 20 % des URLs alors que 5 % sont trop dynamiques et 4 % sont trop longues.

5. Des erreurs dans le fichier robots.txt

Entre les erreurs de format très problématiques dans ce fichier (3,69 % des cas) et la difficulté pour les robots Google de le trouver (environ 10 % des sites), voilà de quoi causer de vrais problèmes d’indexation.

C’est également ainsi que certains propriétaires de sites voient des pages qu’ils ne désiraient pas voir indexer par Google l’être.

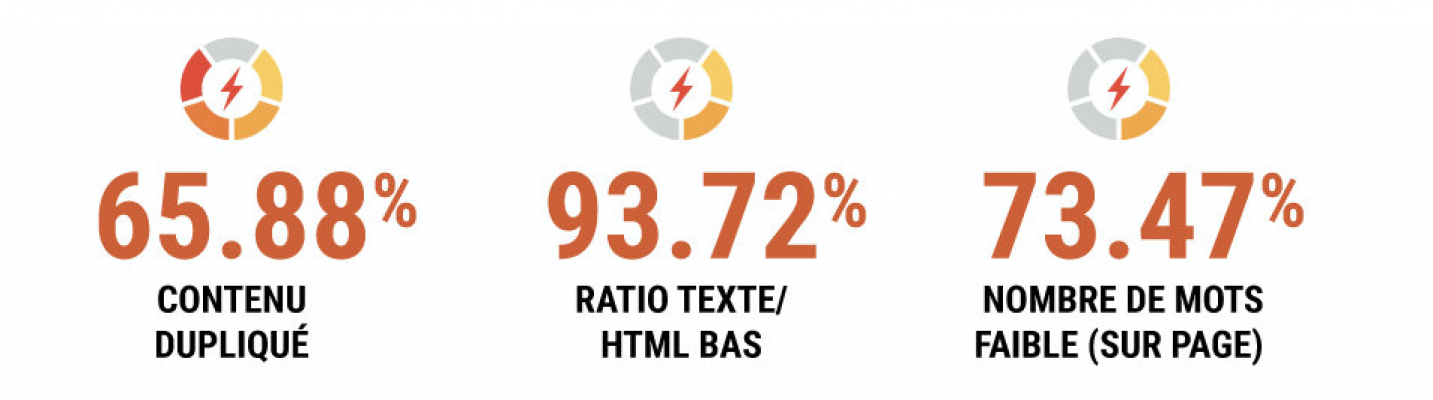

6. Un contenu dupliqué très pénalisant

Ce n’est pas nouveau, Google aime le contenu. En revanche, il réprime sévèrement le « duplicate content ».

67 % des sites Internet en proposeraient toutefois et s’exposeraient donc à une sanction de Google. Généralement, cela prend la forme d’un mauvais référencement de la page concernée mais cela peut aller plus loin si la « triche » est importante puisqu’un déclassement voire même une désindexation est possible.

À lire aussi : Le guide complet pour lutter contre le Duplicate Content

7. Des pages manquant de contenus textuels

Eh oui, chacune des pages d’un site Internet doit, dans l’idéal, disposer d’un minimum de 300 mots pour pouvoir prétendre à un bon référencement sur les moteurs de recherche.

Seulement voilà, 73 % des sites Internet incluraient au moins une page avec un nombre de mots inférieur. Assurément pénalisant pour le référencement.

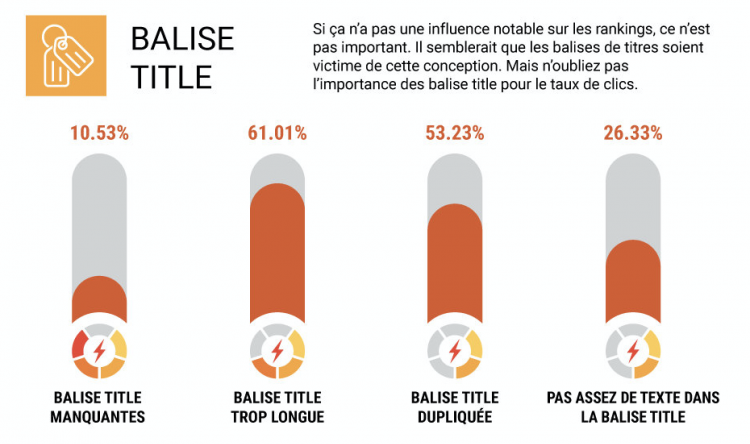

8. Des balises manquantes

Les balises « Title » et « H1 » n’ont certes plus un grand intérêt en matière de référencement mais tout de même, elle reste importante pour doper le taux de clics.

De nombreux porteurs de projet dans le web semblent l’avoir oublié puisque des balises « Title » manquantes sont repérées sur 10 % des sites alors des balises « H1 » manquent sur près des deux tiers des sites Internet.

À lire aussi : SEO : 7 astuces pour rédiger la balise Title de vos pages web

9. Une mauvaise optimisation des images

À l’heure où aucun détail ne doit être négligé pour optimiser le référencement d’un site Internet, l’optimisation des images se veut un passage obligé.

Pourtant, 8 % des sites embarquent des images internes cassées alors qu’un attribut ALT est manquant pour au moins une image sur 65 % des sites web.

À lire aussi : 5 outils pour réduire le poids de vos fichiers et images rapidement

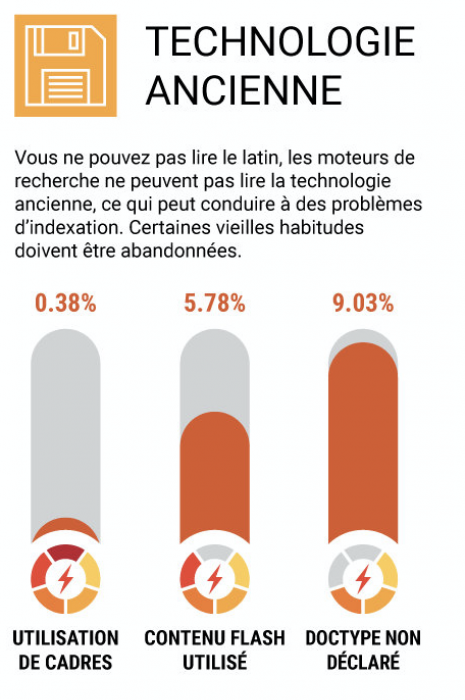

10. L’utilisation de technologies anciennes

Évolution du web oblige, certaines technologies ne sont aujourd’hui plus lues par les moteurs de recherche.

C’est par exemple le cas du Flash. Pourtant, un peu plus de 5 % des sites web proposent encore du contenu en Flash. Dommage car ce dernier ne sera pas indexé et pourra donc priver le site d’un meilleur référencement.

11. Des chargements de pages trop lents

Près du quart des sites Internet voient leur référencement pénaliser par une vitesse de chargement des pages trop lente. Aussi, pour éviter pareil problème, il est temps de penser à optimiser les images pour le web et à mettre en pratique le lazy loading.

À lire aussi : SEO : 8 outils pour tester et analyser la vitesse de votre site

Vous l’avez compris, de nombreuses erreurs sont commises par les propriétaires de sites Internet et beaucoup sont suffisamment importantes pour lourdement pénaliser le référencement.

Aussi, maintenant que vous les connaissez, il ne vous reste qu’à les éviter. D’ailleurs, n’hésitez pas à faire appel à des professionnels de la rédaction sur Redacteur.com pour disposer de contenus qualitatifs suffisamment longs pour qu’ils profitent à votre référencement.