Plus un site est volumineux et plus les erreurs d’optimisation sont monnaie courante.

Contenu dupliqué, liens brisés, métadonnées manquantes, etc., il est difficile de tout vérifier, surtout lorsque l’on est plusieurs à gérer un site. Les erreurs se cumulent vite et votre référencement s’en trouve considérablement impacté.

C’est pour cela qu’utiliser un crawler pour vos contenus va vous faciliter la tâche, car il va détecter les problèmes SEO de votre site Internet à votre place.

Il ne vous restera plus qu’à corriger les erreurs !

Comment fonctionne le crawler SEO ?

En dehors des crawlers des moteurs de recherche comme Googlebot pour Google ou Bingbot pour Bing, il existe deux types de crawler :

- Le crawler de diagnostic, ou crawler SEO, qui va vous aider à améliorer votre référencement naturel.

- Le crawler de veille, plus spécifique, utilisé surtout par les sites E-commerce, qui permet de suivre la politique de tarification de la concurrence.

À la différence des robots de crawl des moteurs de recherche, les crawlers SEO n’indexent pas vos URLs de page. Ils vont se contenter de simuler leurs actions pour identifier chaque erreur technique et vous fournir un rapport plus ou moins étoffé des actions à mettre en œuvre pour améliorer votre référencement naturel.

Structurer son maillage interne

Un maillage interne de qualité est indispensable. Il facilite le crawlage des moteurs de recherche et offre une expérience de navigation optimale à vos visiteurs.

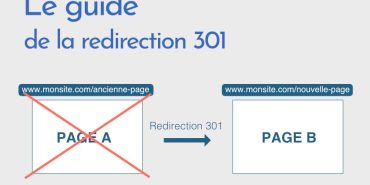

- Les erreurs 404, lourdement sanctionnées par Google, sont des pages inexistantes renvoyées par un lien interne ou externe. Elles sont courantes surtout sur les sites possédant de nombreuses pages, notamment sur les sites E-commerce où les produits ne sont plus référencés, mais dont les liens pointant vers leur fiche sont toujours existants.

- Les mauvaises redirections, quant à elles, ralentissent les crawlers des moteurs de recherche, mais vous risquez également de perdre vos visiteurs s’ils doivent naviguer d’une page à une autre avant d’arriver au contenu final.

Le crawler SEO va donc vous permettre de détecter ces erreurs et vous aider à concevoir un maillage interne efficace.

Un maillage interne de qualité possède une structure de lien bien organisée et une expérience de navigation fluide. Évitez les maillages labyrinthiques, chaque page doit être accessible en 3 ou 4 clics maximum !

À lire aussi : Comment optimiser la mise à jour de vos contenus ?

Éviter le duplicate content

Là encore, le contenu dupliqué fait partie des éléments sanctionnés par les moteurs de recherche. Le plagiat est interdit.

Lorsque vous créez des contenus pour votre site, vérifiez systématiquement que votre contenu soit unique avant de le publier, avec Plagiarism Checker par exemple.

Le crawler SEO va identifier tous vos contenus identiques ou similaires et vous permettre ainsi de corriger vos doublons.

Travailler ses mots clés

Le crawler SEO calcule la densité et le volume de vos mots-clés pour vous fournir un score. C’est un outil idéal pour améliorer son référencement naturel.

À lire aussi : Comment éviter les pages zombies en SEO ?

Soigner ses métadonnées

Le crawler des moteurs de recherche analyse vos contenus à la recherche des mots-clés grâce à vos métadonnées.

Ce sont ces balises META (Title, Alt Tags, Meta description, Hn, etc.) qui indiquent aux crawlers où chercher, d’où la nécessité de les renseigner avec soin. Le crawler SEO va ainsi pointer l’ensemble de vos erreurs de balisage.

Améliorer sa vitesse de chargement

La vitesse de chargement de vos pages affecte considérablement votre référencement et l’expérience utilisateur. Le crawler SEO va mesurer le temps qu’il faut à vos pages pour s’ouvrir sur ordinateur et sur mobile. Ensuite, il vous délivrera les conseils pour améliorer la vitesse de chargement de vos pages.

Surveiller son netlinking

Le netlinking fait partie des critères principaux de référencement des moteurs de recherche. Avec un crawler SEO, vous serez en mesure d’identifier quel site a fait un lien vers votre site web.

Si le site ne fait pas autorité ou est de mauvaise qualité, désavouez le lien entrant (ou backlink), vous risqueriez d’être sanctionné par Google !

10 outils pour crawler votre site Web

Il existe de nombreux outils de crawl SEO performants qui permettent d’analyser un site de manière approfondie. Certains sont accessibles gratuitement, comme l’outil d’inspection d’URL de Google proposé aux webmasters et gestionnaires de sites. Les outils payants intègrent bien souvent des services à valeur ajoutée en cumulant plusieurs fonctions qui peuvent faciliter l’optimisation.

Les outils freemium sont des intermédiaires qui permettent de tester une solution avant d’acheter une licence ou de souscrire un abonnement. Le choix d’un crawler dépend avant tout de vos besoins, de l’envergure de votre site, du volume de vos pages à analyser et de vos priorités. Voici un panorama des principaux outils et quelques astuces pour en tirer le meilleur bénéfice possible.

Les crawlers SEO gratuits

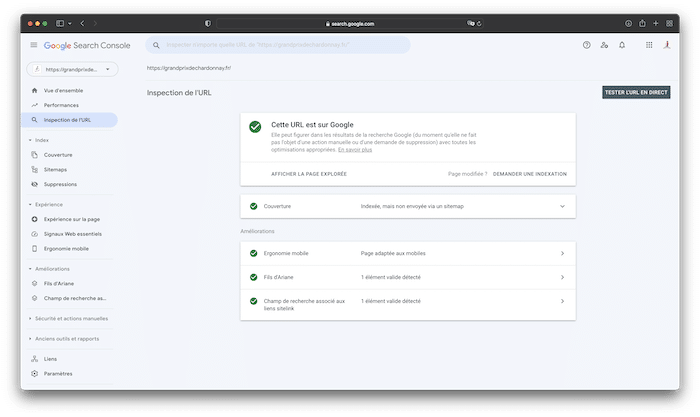

1. L’outil d’inspection d’URL de Google

S’il y a bien un outil incontournable pour détecter un éventuel problème de référencement ou d’indexation, c’est l’outil d’inspection d’URL proposé dans Search Console. Accessible à tous les éditeurs de sites qui ont créé un compte Google Analytics, cette plateforme complète peut vous donner de précieuses indications sur les performances de votre site Internet.

L’outil d’inspection d’URL permet d’effectuer une analyse approfondie à partir d’une page spécifique. Son utilisation est simple, puisqu’il suffit de saisir l’URL de la page pour obtenir un rapport détaillé. De nombreuses informations peuvent être mises en lumière :

- Le suivi de l’indexation : si vous venez d’ajouter une page ou un groupe de pages à votre site, il est primordial de vérifier que celles-ci ont bien été prises en compte par les moteurs de recherche.

- Les éventuels problèmes d’indexation : si vos nouvelles pages sont en ligne depuis plusieurs semaines, l’absence d’indexation peut révéler un dysfonctionnement. L’outil vous aidera alors à détecter les points d’amélioration en explorant le code source de votre site. Les erreurs courantes peuvent inclure ou fournit des informations sur la version indexée par Google d’une page spécifique. Ces informations incluent les erreurs d’implémentation AMP (Accelerated Mobile Pages) ou un mauvais paramétrage du fichier robots.txt.

Une fois les difficultés techniques résolues, il est possible de demander l’indexation de la page qui posait problème en transmettant l’URL au moteur de recherche. Cette action vise à accélérer le passage des « Googlebots » sur une page donnée de votre site. Un délai de quelques jours peut être nécessaire pour relancer ce processus d’indexation.

2. Ahrefs

Ahrefs fait partie des crawlers SEO incontournables. En réalité, il offre des perspectives beaucoup plus larges que le crawling, puisqu’il réunit l’analyse sémantique, l’audit de référencement technique et le suivi du positionnement de votre site dans les SERP –pages de résultats de recherche). S’y ajoutent l’analyse de backlinks et une vue des résultats obtenus par vos principaux concurrents.

L’accès intégral à l’ensemble des fonctionnalités est payant. Mais il est possible de cumuler gratuitement les services Site Explorer et Site Audit. Il s’agit donc d’un outil freemium qui offre un excellent compromis pour se familiariser avec le crawl et les informations qui en découlent. Dans sa version gratuite, il peut également convenir aux sites de petite envergure, qui n’ont pas de forts besoins en termes de stratégie marketing.

Beaucoup d’utilisateurs ont recours à Ahrefs pour obtenir des rapports détaillés concernant les liens brisés, les pages d’erreur 404 et les contenus dupliqués.

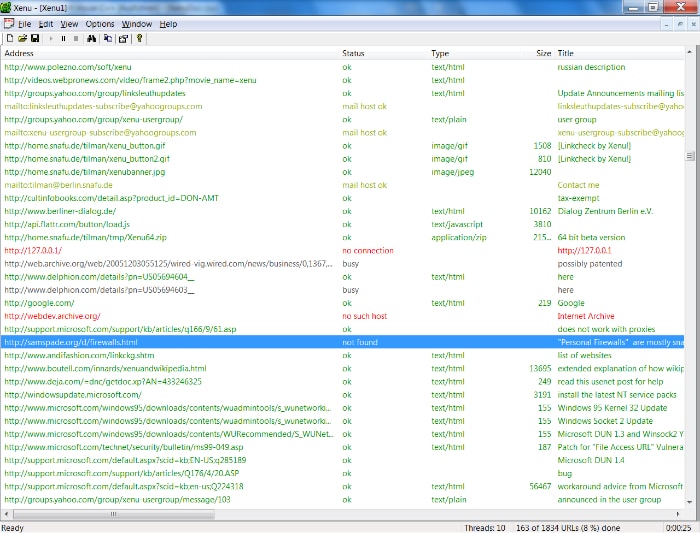

3. Xenu

Xenu est un crawler SEO gratuit Xenu est très efficace. Léger et facile à utiliser, il scanne votre site web en quelques minutes, selon la taille du site, pour vous fournir un rapport complet (erreurs de maillage interne et de balisage, temps de chargement, liens entrants, etc.).

4. LinkExaminer

LinkExaminer est un crawler SEO gratuit qui parcourt vos liens à la recherche d’éventuelles erreurs et identifie les pages dupliquées.

5. Screaming Frog

Avec Screaming Frog, vous pourrez explorer jusqu’à 500 URL gratuitement. Ce crawler SEO est très efficace et très complet. Il trouve instantanément les liens rompus et le contenu dupliqué, analyse vos métadonnées et vous permet de générer un fichier sitemaps XML.

Les crawlers SEO payants

6. OnCrawl

OnCrawl est une solution payante qui scanne et analyse quotidiennement votre site, le crawler vous permet également une analyse de logs.

Tourné vers l’innovation, cet outil reproduit le comportement des robots des moteurs de recherche. Il s’appuie sur le machine learning pour générer des rapports pointus, tant en ce qui concerne les logs que l’indexation.

7. Botify

Botify est un crawler SEO payant qui effectue un scan complet de votre site web pour vous délivrer des données pertinentes afin d’améliorer votre SEO.

Cet outil créé en France par un professionnel du référencement met en exergue les principaux points de blocage techniques, comme une vitesse de chargement trop faible ou des balises SEO mal renseignées.

8. SEMrush

Enfin, SEMrush scanne votre site à la recherche de toutes les erreurs SEO possibles. C’est un outil assez complet, notamment pour votre recherche de mot clé.

Grâce à de nombreuses fonctionnalités transverses, comme l’analyse de mots-clés et l’analyse concurrentielle, les opportunités de progression sont réelles. L’interface claire et intuitive, associée aux rapports exportables, simplifie le déploiement d’actions SEO concrètes.

À lire aussi : Le guide complet pour lutter contre le Duplicate Content

9. DeepCrawl

DeepCrawl est un outil d’optimisation SEO particulièrement adapté aux sites de grande envergure, composés d’un grand nombre de pages. En effet, il est accessible en mode cloud et permet donc d’externaliser le crawling. Cette fonctionnalité est avantageuse à différents niveaux :

- les analyses sont plus rapides, puisqu’un nombre important de crawls peuvent être lancés simultanément ;

- le risque de panne ou de dysfonctionnement du site lié à la monopolisation de la mémoire vive des serveurs internes est réduit à zéro ;

- il n’est plus nécessaire de paramétrer le crawling lorsque l’entreprise n’est pas en activité (la nuit ou pendant les jours de fermeture). Les analyses peuvent être lancées à n’importe quel moment sans incidence.

D’autre part, DeepCrawl permet de réaliser des crawls spécifiques pour recueillir des informations précises, comme les problèmes d’indexation d’un groupe de pages donné, la viabilité des sitemaps générés ou les URL de backlinks. Cette segmentation permet de gagner un temps précieux et d’obtenir des datas fiables et hiérarchisées.

10. NetPeak Spider

Accessible dans une version gratuite très limitée, NetPeak Spider déploie tout son potentiel lorsque ses fonctionnalités payantes sont exploitées. Il est possible de choisir la formule la plus adaptée à ses objectifs et à la taille de son site.

Cet outil est orienté vers l’optimisation SEO technique. Les données fournies par les crawls effectués permettent de rapidement améliorer le référencement d’un site : pages d’erreur générées, données manquantes dans le fichier robots.txt, en-têtes et balises incomplètes.

Grâce à des indicateurs clairs, il est possible de détecter facilement les points d’amélioration et d’agir rapidement en cas de problème. Avec l’export des rapports générés au format .xls, les données utiles peuvent être organisées, triées et croisées.

Notre astuce pour bien configurer un crawler SEO

La plupart des outils de crawl, notamment ceux qui proposent une version payante, peuvent être personnalisés. Cette étape de configuration est essentielle pour éviter les écueils au cours de l’utilisation. Dans la section dédiée aux paramètres de l’outil, vous serez invité à saisir des informations relatives à votre site. Vérifiez notamment les limites de mémoire de l’outil, qui peuvent être augmentées en fonction du volume de pages à analyser.

Éviter le duplicate content, surtout lorsque l’on possède un site E-commerce où les fiches produits peuvent vite avoir un contenu similaire, peut s’avérer fastidieux.

Nos équipes de rédacteurs web sont là pour générer un contenu unique et de qualité, pensez-y !